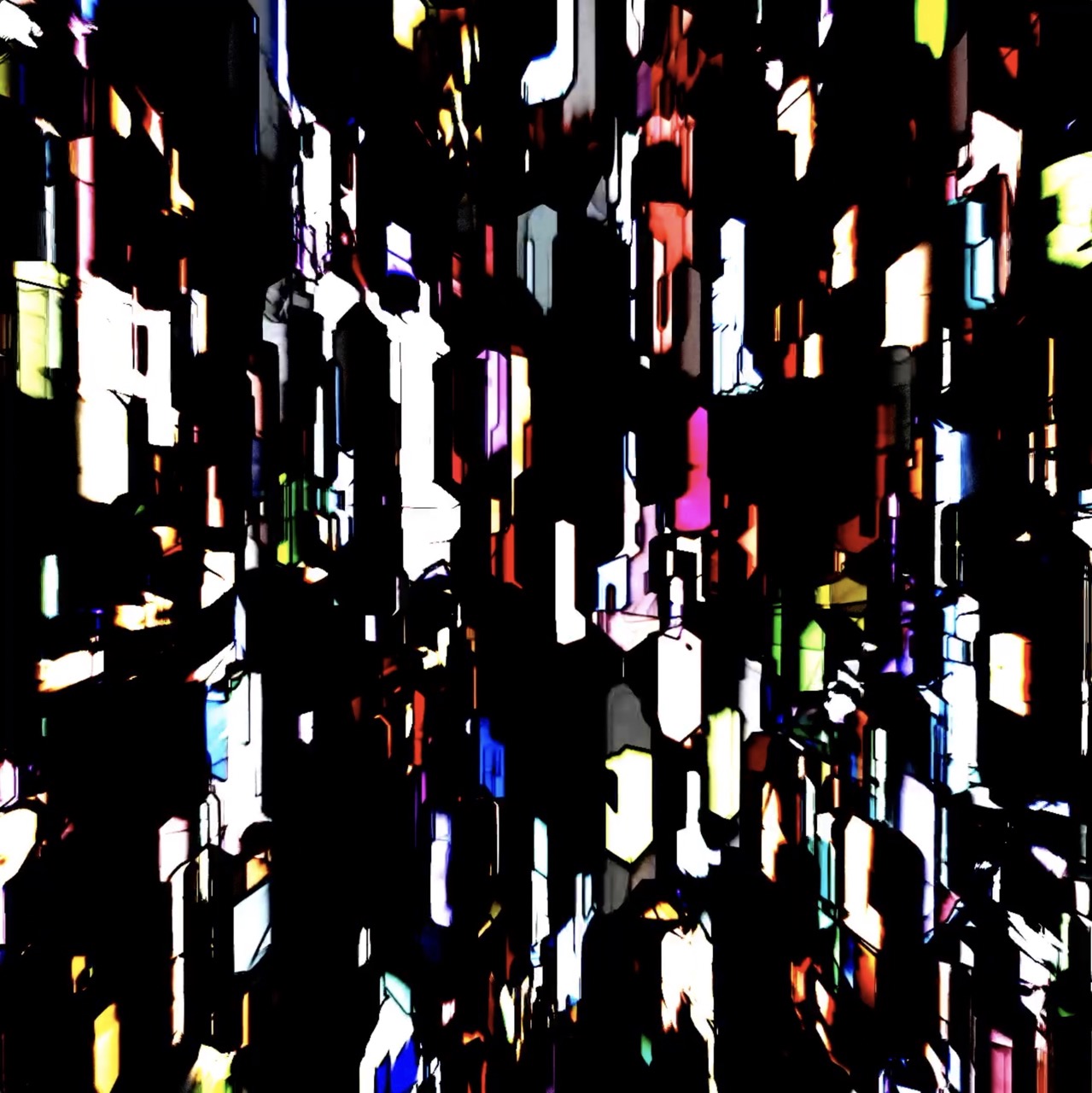

Digital Live Art steht für die Symbiose aus Bild, Musik, Bewegung und Technik. Sie will musikalische Eindrücke verstärken und mit ihnen interagieren. Verbindungen herstellen zwischen Künstlern, Raum, Publikum.

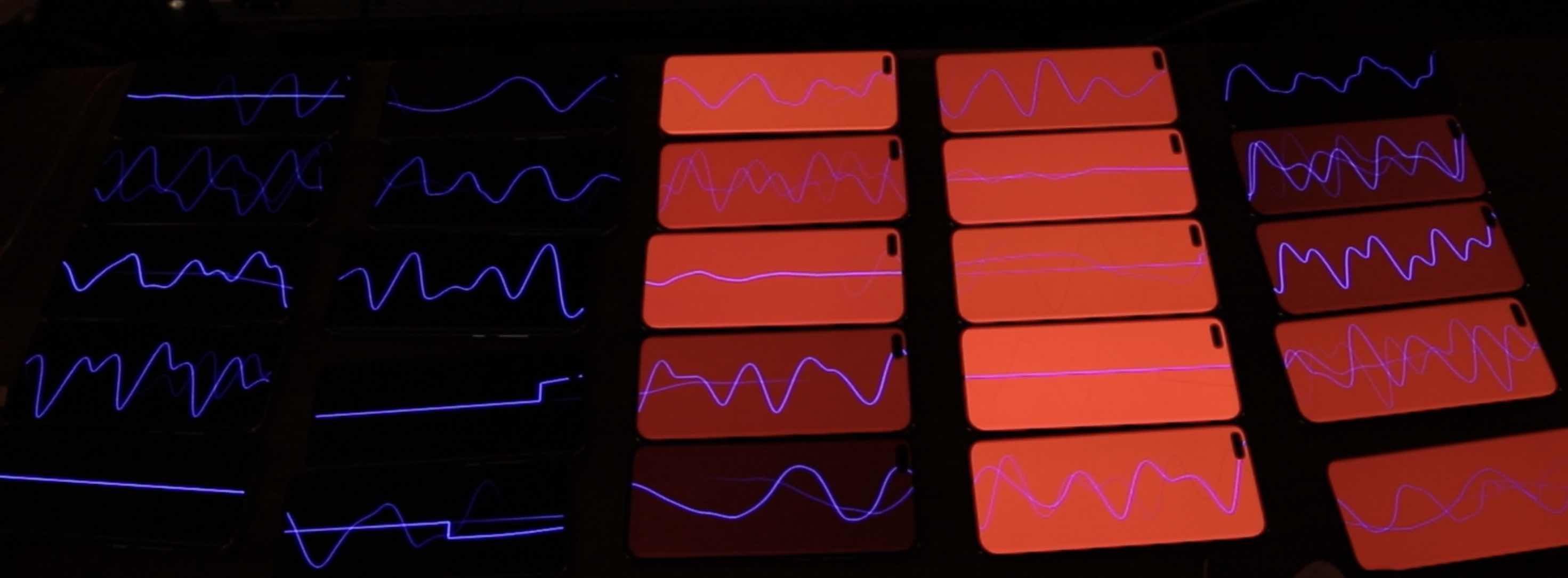

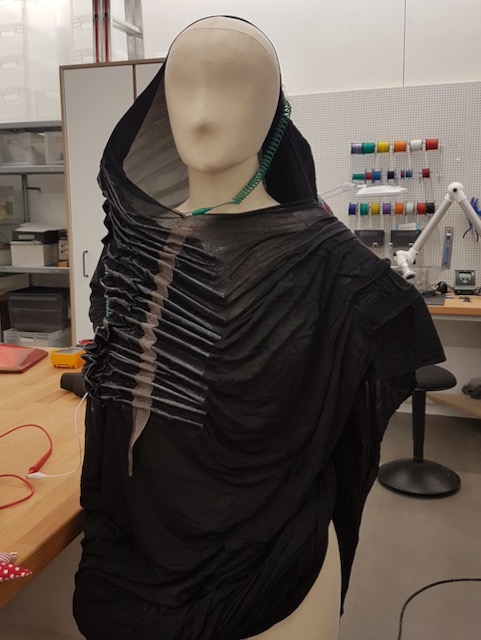

Das Instrument soll weitergedacht werden: Alles kann ein Instrument sein!

Digital Live Art stands for the symbiosis of image, music, movement and technology. She wants to amplify musical impressions and interact with them. Creating connections between artists, space, audience.

The instrument should be further thought out: Everything can be an instrument!

.jpeg)